Intel و دیگران متعهد به ساخت ابزارهای هوش مصنوعی مولد باز برای شرکت هستند

به گزارش اپ خونه، آیا هوش مصنوعی مولد طراحی شده برای شرکت (به عنوان مثال، هوش مصنوعی که گزارشها، فرمولهای صفحهگسترده و غیره را به صورت خودکار تکمیل میکند) میتواند قابلیت همکاری داشته باشد؟

همراه با مجموعهای از سازمانها از جمله Cloudera و Intel، بنیاد لینوکس – سازمان غیرانتفاعی که از تعداد فزایندهای از تلاشهای منبع باز پشتیبانی و نگهداری میکند – قصد دارد این موضوع را کشف کند.

بنیاد لینوکس راهاندازی پلتفرم باز برای هوش مصنوعی سازمانی (OPEA) ، پروژهای برای تقویت توسعه سیستمهای هوش مصنوعی مولد باز، چند ارائهدهنده و ترکیبپذیر (یعنی ماژولار) را اعلام کرد.

زیر نظر LF AI و سازمان داده بنیاد لینوکس، که بر ابتکارات پلتفرم مرتبط با هوش مصنوعی و داده تمرکز دارد، هدف OPEA هموار کردن راه برای انتشار سیستمهای هوش مصنوعی مولد «سختشده» و «مقیاسپذیر» خواهد بود.

ابراهیم حداد، مدیر اجرایی LF AI و Data، در یک بیانیه مطبوعاتی گفت: بهترین نوآوری منبع باز از سراسر اکوسیستم در راه است.

حداد گفت: “OPEA با ایجاد یک چارچوب دقیق و قابل ترکیب که در خط مقدم پشته های فناوری قرار دارد، امکانات جدیدی را در هوش مصنوعی باز خواهد کرد. این ابتکار گواهی بر ماموریت ما برای هدایت نوآوری منبع باز و همکاری در هوش مصنوعی و جوامع داده تحت یک مدل حکومتی خنثی و باز است.”

علاوه بر Cloudera و Intel، OPEA – یکی از پروژههای Sandbox بنیاد لینوکس، یک نوع برنامه انکوباتور – در میان اعضای شرکتهای سنگین وزن مانند اینتل، Red Hat متعلق به IBM، Hugging Face، Domino Data Lab، MariaDB و VMware به حساب میآید.

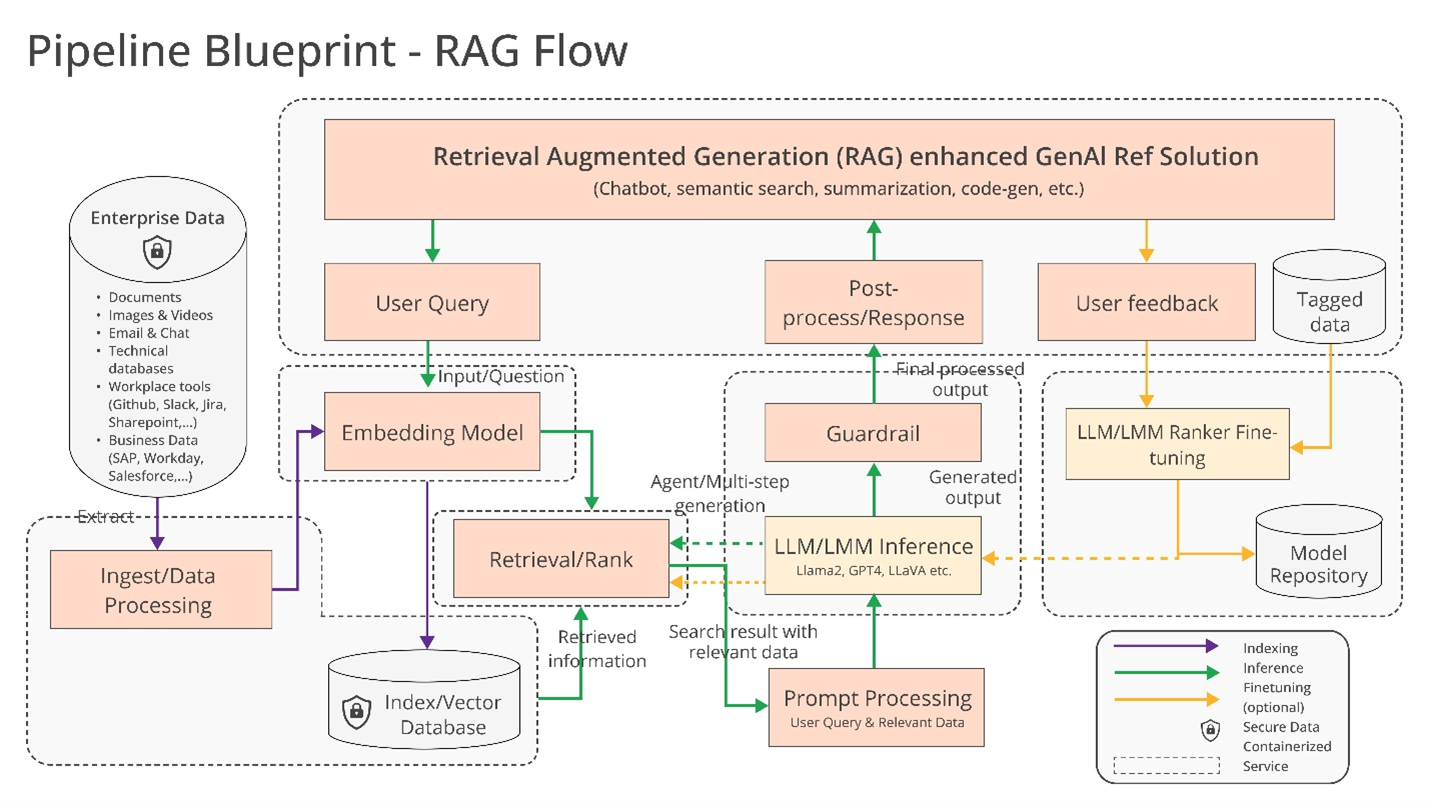

پس دقیقاً چه چیزی ممکن است با هم بسازند؟ حداد به چند احتمال اشاره میکند، مانند پشتیبانی «بهینهشده» از زنجیرههای ابزار و کامپایلرهای هوش مصنوعی، که بار کاری هوش مصنوعی را قادر میسازد تا در اجزای سختافزاری مختلف اجرا شود، و همچنین خطوط لوله «ناهمگن» برای تولید تقویتشده بازیابی (RAG).

RAG به طور فزاینده ای در برنامه های کاربردی سازمانی هوش مصنوعی مولد محبوب می شود، و فهمیدن دلیل آن دشوار نیست. پاسخها و اقدامات بیشتر مدلهای هوش مصنوعی مولد محدود به دادههایی است که بر اساس آنها آموزش دیدهاند.

اما با RAG، پایگاه دانش یک مدل را می توان به اطلاعات خارج از داده های آموزشی اصلی گسترش داد.

مدلهای RAG به این اطلاعات خارجی اشاره میکنند قبل از ایجاد پاسخ یا انجام یک کار – میتواند به شکل دادههای اختصاصی شرکت، یک پایگاه داده عمومی یا ترکیبی از این دو باشد .

نموداری که مدل های RAG را توضیح می دهد

Intel در بیانیه مطبوعاتی خود جزئیات بیشتری را ارائه کرد :

شرکتها با رویکرد خودت انجام بده [به RAG] به چالش کشیده میشوند، زیرا هیچ استانداردی در بین اجزای سازنده وجود ندارد که به شرکتها اجازه میدهد راهحلهای RAG را انتخاب و به کار ببرند که باز و قابل همکاری هستند و به آنها کمک میکند سریع به بازار برسند.

OPEA قصد دارد با همکاری با صنعت برای استانداردسازی اجزا از جمله چارچوب ها، نقشه های معماری و راه حل های مرجع به این مسائل رسیدگی کند.

ارزیابی همچنین بخش مهمی از آنچه OPEA با آن مقابله می کند خواهد بود.

OPEA در مخزن GitHub خود ، روبریکی را برای درجهبندی سیستمهای هوش مصنوعی مولد در چهار محور پیشنهاد میکند: عملکرد، ویژگیها، قابلیت اطمینان و آمادگی «در سطح سازمانی».

عملکرد همانطور که OPEA تعریف می کند به معیارهای “جعبه سیاه” از موارد استفاده در دنیای واقعی مربوط می شود. ویژگی ها ارزیابی قابلیت همکاری سیستم، انتخاب های استقرار و سهولت استفاده است.

قابلیت اعتماد به توانایی یک مدل هوش مصنوعی برای تضمین «استقامت» و کیفیت میپردازد و آمادگی سازمانی بر الزامات برای راهاندازی و راهاندازی یک سیستم بدون مسائل عمده تمرکز دارد.

راشل روملیوتیس، مدیر استراتژی منبع باز Intel، می گوید که OPEA با جامعه منبع باز همکاری خواهد کرد تا آزمایش هایی را بر اساس این عنوان ارائه دهد، همچنین ارزیابی و درجه بندی استقرارهای هوش مصنوعی مولد را در صورت درخواست ارائه می دهد.

تلاش های دیگر OPEA در حال حاضر کمی در هوا است. اما حداد پتانسیل توسعه مدل باز را در امتداد خطوط رو به گسترش خانواده Llama متا و DBRX Databricks قرار داد .

در این راستا، در مخزن OPEA، اینتل/Intel قبلاً پیادهسازیهای مرجعی را برای یک چت ربات مبتنی بر هوش مصنوعی، خلاصهکننده اسناد و تولیدکننده کد بهینهسازی شده برای سختافزار Xeon 6 و Gaudi 2 ارائه کرده است.

اکنون، اعضای OPEA به وضوح در ساخت ابزار برای هوش مصنوعی مولد سازمانی سرمایه گذاری کرده اند (و به نفع خود هستند).

کلودرا اخیراً شراکت هایی را برای ایجاد آنچه که به عنوان یک “اکوسیستم هوش مصنوعی” در فضای ابری ارائه می کند، راه اندازی کرده است.

Domino مجموعهای از برنامهها را برای ساخت و ممیزی هوش مصنوعی مولد پیشبرد کسبوکار ارائه میکند و VMware – با جهت گیری به سمت زیرساخت هوش مصنوعی سازمانی – در آگوست گذشته محصولات محاسباتی “هوش مصنوعی خصوصی” جدیدی را عرضه کرد.

سوال این است که آیا این فروشندگان واقعاً با هم همکاری خواهند کرد تا ابزارهای هوش مصنوعی متقابل سازگار را تحت OPEA بسازند.

یک مزیت آشکار برای انجام این کار وجود دارد. مشتریان با خوشحالی از چندین فروشنده بسته به نیاز، منابع و بودجه خود استفاده می کنند.